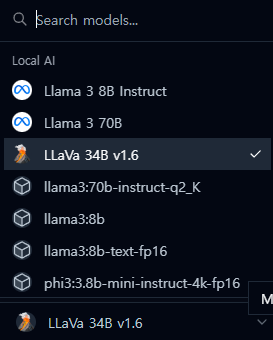

In a comprehensive evaluation, we tested the LLaVa 34B model, a multimodal large language model celebrated for its ability to process and interpret both text and image data. The focus of this study was to assess the model’s proficiency in image recognition while operating in English, juxtaposed with its performance in Korean. Our methodology involved exposing the model to a variety of image datasets, requiring it to identify and describe the visual content. While the results showcased a high degree of accuracy and descriptive power in image recognition when operating in English, it became evident that the model’s performance was markedly less adept when processing tasks in Korean. This disparity highlights the challenges faced by large language models in maintaining consistent performance across different languages, particularly in multimodal tasks. These findings have significant implications for the development of language-specific training approaches and the optimization of multimodal models for diverse linguistic backgrounds.

텍스트와 이미지 데이터를 모두 처리하고 해석할 수 있는 능력으로 유명한 멀티 모달 대형 언어 모델인 LLaVa 34B 모델을 테스트했습니다. 이 테스트 초점은 모델이 영어로 작동할 때의 이미지 인식 능력과 한국어로의 성능을 비교하는 것이었습니다. 우리의 방법론은 모델에 다양한 이미지 데이터 세트를 노출시키고 시각적 내용을 식별하고 묘사하도록 요구하는 것을 포함했습니다. 영어로 작동할 때 이미지 인식에서 높은 정확도와 묘사력을 보여주었지만, 한국어로 처리하는 작업에서는 모델의 성능이 현저히 떨어지는 것으로 나타났습니다. 이러한 차이는 멀티모달 작업에서 다양한 언어에 걸쳐 일관된 성능을 유지하는 데 대한 대형 언어 모델이 직면하는 도전을 강조합니다. 이러한 발견은 언어별 훈련 접근 방식의 개발과 다양한 언어 배경에 대한 멀티모달 모델의 최적화에 중요한 함의를 가집니다